Todos han escuchado sobre los nuevos avances en inteligencia artificial, y especialmente el aprendizaje automático. También ha escuchado predicciones utópicas o apocalípticas sobre lo que significan esos avances. Se les ha llevado a presagiar la inmortalidad o el fin del mundo, y se ha escrito mucho sobre ambas posibilidades. Pero las IA más sofisticadas aún están lejos de poder resolver los problemas que los humanos de cuatro años logran con facilidad. A pesar del nombre impresionante, la inteligencia artificial consiste en gran medida en técnicas para detectar patrones estadísticos en grandes conjuntos de datos. Hay mucho más en el aprendizaje humano.

¿Cómo podemos saber tanto sobre el mundo que nos rodea? Aprendemos muchísimo incluso cuando somos niños pequeños; los niños de cuatro años ya saben de plantas, animales y máquinas; deseos, creencias y emociones; incluso dinosaurios y naves espaciales.

La ciencia ha extendido nuestro conocimiento sobre el mundo a lo inimaginablemente grande y lo infinitesimalmente pequeño, hasta el borde del universo y el comienzo de los tiempos. Y usamos ese conocimiento para hacer nuevas clasificaciones y predicciones, imaginar nuevas posibilidades y hacer que sucedan cosas nuevas en el mundo. Pero todo lo que nos llega del mundo es una corriente de fotones que golpean nuestras retinas y las perturbaciones del aire en nuestros tímpanos. ¿Cómo aprendemos tanto sobre el mundo cuando la evidencia que tenemos es tan limitada? ¿Y cómo hacemos todo esto con las pocas libras de sustancia gris que se encuentra detrás de nuestros ojos?

La mejor respuesta hasta ahora es que nuestros cerebros realizan cálculos sobre los datos concretos, particulares y desordenados que llegan a nuestros sentidos, y esos cálculos producen representaciones precisas del mundo. Las representaciones parecen ser estructuradas, abstractas y jerárquicas; incluyen la percepción de objetos tridimensionales, las gramáticas que subyacen al lenguaje y capacidades mentales como la "teoría de la mente", que nos permite comprender lo que piensan otras personas. Esas representaciones nos permiten hacer una amplia gama de nuevas predicciones e imaginar muchas posibilidades nuevas de una manera humana distintivamente creativa.

Este tipo de aprendizaje no es el único tipo de inteligencia, pero es particularmente importante para los seres humanos. Y es el tipo de inteligencia que es una especialidad de los niños pequeños. Aunque los niños son dramáticamente malos en la planificación y la toma de decisiones, son los mejores alumnos del universo. Gran parte del proceso de convertir datos en teorías ocurre antes de que tengamos cinco años.

Desde Aristóteles y Platón, ha habido dos formas básicas de abordar el problema de cómo sabemos lo que sabemos, y siguen siendo los enfoques principales en el aprendizaje automático. Aristóteles abordó el problema de abajo hacia arriba: comience con los sentidos: el flujo de fotones y las vibraciones del aire (o los píxeles o las muestras de sonido de una imagen digital o grabación) y vea si puede extraer patrones de ellos. Este enfoque fue llevado más allá por asociacionistas clásicos como los filósofos David Hume y JS Mill y más tarde por psicólogos del comportamiento, como Pavlov y BF Skinner. Desde este punto de vista, la abstracción y la estructura jerárquica de las representaciones es una especie de ilusión, o al menos un epifenómeno. Todo el trabajo se puede hacer por asociación y detección de patrones, especialmente si hay suficientes datos.

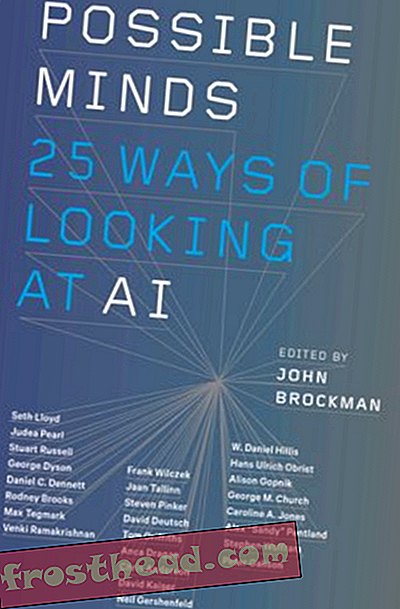

Mentes posibles: 25 formas de ver la IA

La luminaria del mundo de la ciencia John Brockman reúne a veinticinco de las mentes científicas más importantes, personas que han estado pensando en el campo de la inteligencia artificial para la mayoría de sus carreras, para un examen de mesa redonda sin paralelo sobre la mente, el pensamiento, la inteligencia y lo que significa Se humano.

ComprarCon el tiempo, ha habido una oscilación entre este enfoque de abajo hacia arriba para el misterio del aprendizaje y la alternativa de Platón, de arriba hacia abajo. Tal vez obtenemos conocimiento abstracto de datos concretos porque ya sabemos mucho, y especialmente porque ya tenemos una serie de conceptos abstractos básicos, gracias a la evolución. Al igual que los científicos, podemos usar esos conceptos para formular hipótesis sobre el mundo. Luego, en lugar de tratar de extraer patrones de los datos sin procesar, podemos hacer predicciones sobre cómo deberían verse los datos si esas hipótesis son correctas. Junto con Platón, filósofos y psicólogos "racionalistas" como Descartes y Noam Chomsky adoptaron este enfoque.

Aquí hay un ejemplo cotidiano que ilustra la diferencia entre los dos métodos: resolver la plaga de spam. Los datos consisten en una larga lista sin clasificar de mensajes en su bandeja de entrada. La realidad es que algunos de estos mensajes son genuinos y otros son spam. ¿Cómo puedes usar los datos para discriminar entre ellos?

Considere la técnica de abajo hacia arriba primero. Notará que los mensajes de spam tienden a tener características particulares: una larga lista de destinatarios, orígenes en Nigeria, referencias a premios de un millón de dólares o Viagra. El problema es que los mensajes perfectamente útiles también pueden tener estas características. Si observa suficientes ejemplos de correos electrónicos no deseados y no deseados, es posible que vea no solo que los correos no deseados tienden a tener esas características, sino que las características tienden a combinarse de manera particular (Nigeria más un millón de dólares significa problemas). De hecho, puede haber algunas correlaciones sutiles de alto nivel que discriminen los mensajes de spam de los útiles: un patrón particular de errores ortográficos y direcciones IP, por ejemplo. Si detecta esos patrones, puede filtrar el spam.

Las técnicas ascendentes de aprendizaje automático hacen precisamente esto. El alumno obtiene millones de ejemplos, cada uno con un conjunto de características y cada uno etiquetado como spam (o alguna otra categoría) o no. La computadora puede extraer el patrón de características que distingue a los dos, incluso si es bastante sutil.

¿Qué tal el enfoque de arriba hacia abajo? Recibo un correo electrónico del editor de la revista Journal of Clinical Biology . Se refiere a uno de mis documentos y dice que les gustaría publicar un artículo mío. Sin Nigeria, sin Viagra, sin millones de dólares; El correo electrónico no tiene ninguna de las características del spam. Pero al usar lo que ya sé y pensar de manera abstracta sobre el proceso que produce spam, puedo darme cuenta de que este correo electrónico es sospechoso:

1. Sé que los spammers intentan extraer dinero de las personas apelando a la codicia humana.

2. También sé que las revistas legítimas de "acceso abierto" han comenzado a cubrir sus costos cobrando a los autores en lugar de a los suscriptores, y que no practico nada como la biología clínica.

Ponga todo eso junto y puedo producir una buena hipótesis sobre el origen de ese correo electrónico. Está diseñado para engañar a los académicos para que paguen por "publicar" un artículo en una revista falsa. El correo electrónico fue el resultado del mismo proceso dudoso que los otros correos electrónicos no deseados, a pesar de que no se parecía en nada a ellos. Puedo sacar esta conclusión de un solo ejemplo, y puedo seguir probando mi hipótesis más allá de cualquier cosa en el correo electrónico, buscando en Google el "editor".

En términos de computadora, comencé con un "modelo generativo" que incluye conceptos abstractos como la codicia y el engaño y describe el proceso que produce estafas por correo electrónico. Eso me permite reconocer el clásico correo no deseado nigeriano, pero también me permite imaginar muchos tipos diferentes de posible correo no deseado. Cuando recibo el correo electrónico del diario, puedo trabajar hacia atrás: "Parece el tipo de correo que saldría de un proceso de generación de spam".

La nueva emoción sobre la IA se debe a que los investigadores de IA han producido recientemente versiones poderosas y efectivas de ambos métodos de aprendizaje. Pero no hay nada profundamente nuevo sobre los métodos en sí mismos.

Aprendizaje profundo ascendente

En la década de 1980, los informáticos idearon una forma ingeniosa de hacer que las computadoras detectaran patrones en los datos: arquitectura conexionista o de redes neuronales (la parte "neuronal" era, y sigue siendo, metafórica). El enfoque cayó en la crisis en la década de 1990, pero recientemente ha sido revivido con poderosos métodos de "aprendizaje profundo" como DeepMind de Google.

Por ejemplo, puede darle a un programa de aprendizaje profundo un montón de imágenes de Internet con la etiqueta "gato", otras con la etiqueta "casa", y así sucesivamente. El programa puede detectar los patrones que diferencian los dos conjuntos de imágenes y usar esa información para etiquetar nuevas imágenes correctamente. Algunos tipos de aprendizaje automático, llamados aprendizaje no supervisado, pueden detectar patrones en los datos sin ninguna etiqueta; simplemente buscan grupos de características, lo que los científicos llaman análisis factorial. En las máquinas de aprendizaje profundo, estos procesos se repiten en diferentes niveles. Algunos programas pueden incluso descubrir características relevantes a partir de los datos en bruto de píxeles o sonidos; la computadora puede comenzar detectando los patrones en la imagen en bruto que corresponden a bordes y líneas y luego encontrar los patrones en esos patrones que corresponden a caras, y así sucesivamente.

Otra técnica de abajo hacia arriba con una larga historia es el aprendizaje por refuerzo. En la década de 1950, BF Skinner, basándose en el trabajo de John Watson, programó famosas palomas para realizar acciones elaboradas, incluso guiando misiles lanzados desde el aire a sus objetivos (un eco inquietante de la IA reciente) dándoles un programa particular de recompensas y castigos. . La idea esencial era que las acciones que fueron recompensadas se repetirían y las que fueron castigadas no, hasta que se lograra el comportamiento deseado. Incluso en los días de Skinner, este proceso simple, repetido una y otra vez, podría conducir a un comportamiento complejo. Las computadoras están diseñadas para realizar operaciones simples una y otra vez en una escala que eclipsa la imaginación humana, y los sistemas computacionales pueden aprender habilidades notablemente complejas de esta manera.

Por ejemplo, los investigadores de DeepMind de Google utilizaron una combinación de aprendizaje profundo y aprendizaje por refuerzo para enseñar a una computadora a jugar videojuegos de Atari. La computadora no sabía nada sobre cómo funcionaban los juegos. Comenzó actuando de manera aleatoria y obtuvo información solo sobre cómo se veía la pantalla en cada momento y qué tan bien había marcado. El aprendizaje profundo ayudó a interpretar las características en la pantalla, y el aprendizaje por refuerzo recompensó al sistema por puntajes más altos. La computadora se volvió muy buena jugando varios de los juegos, pero también bombardeó por completo a otros que eran tan fáciles de dominar para los humanos.

Una combinación similar de aprendizaje profundo y aprendizaje de refuerzo ha permitido el éxito de DeepMind's AlphaZero, un programa que logró vencer a jugadores humanos tanto en ajedrez como en Go, equipado con solo un conocimiento básico de las reglas del juego y algunas capacidades de planificación. AlphaZero tiene otra característica interesante: funciona jugando cientos de millones de juegos contra sí mismo. Al hacerlo, elimina errores que condujeron a pérdidas, y repite y elabora estrategias que condujeron a victorias. Dichos sistemas, y otros que involucran técnicas llamadas redes generativas de confrontación, generan datos y observan datos.

Cuando tiene el poder computacional para aplicar esas técnicas a conjuntos de datos muy grandes o millones de mensajes de correo electrónico, imágenes de Instagram o grabaciones de voz, puede resolver problemas que antes parecían muy difíciles. Esa es la fuente de gran parte de la emoción en la informática. Pero vale la pena recordar que esos problemas, como reconocer que una imagen es un gato o una palabra hablada es Siri, son triviales para un niño humano. Uno de los descubrimientos más interesantes de la informática es que los problemas que son fáciles para nosotros (como identificar gatos) son difíciles para las computadoras, mucho más difíciles que jugar al ajedrez o Go. Las computadoras necesitan millones de ejemplos para clasificar objetos que podemos categorizar con solo unos pocos. Estos sistemas ascendentes pueden generalizarse a nuevos ejemplos; pueden etiquetar una nueva imagen como un gato con bastante precisión sobre todo. Pero lo hacen de maneras muy diferentes de cómo los humanos se generalizan. Algunas imágenes casi idénticas a una imagen de gato no serán identificadas por nosotros como gatos. Otros que se ven como un desenfoque aleatorio lo serán.

Modelos bayesianos de arriba hacia abajo

El enfoque de arriba hacia abajo jugó un papel importante en la IA temprana, y en la década de 2000 también experimentó un renacimiento, en forma de modelos generativos probabilísticos o bayesianos.

Los primeros intentos de utilizar este enfoque enfrentaron dos tipos de problemas. Primero, la mayoría de los patrones de evidencia podrían explicarse en principio por muchas hipótesis diferentes: es posible que el mensaje de correo electrónico de mi diario sea genuino, simplemente no parece probable. En segundo lugar, ¿de dónde provienen los conceptos que utilizan los modelos generativos en primer lugar? Platón y Chomsky dijeron que naciste con ellos. Pero, ¿cómo podemos explicar cómo aprendemos los últimos conceptos de la ciencia? ¿O cómo incluso los niños pequeños entienden acerca de los dinosaurios y los cohetes?

Los modelos bayesianos combinan modelos generativos y pruebas de hipótesis con la teoría de probabilidad, y abordan estos dos problemas. Un modelo bayesiano le permite calcular la probabilidad de que una hipótesis particular sea cierta, dados los datos. Y haciendo pequeños pero sistemáticos ajustes a los modelos que ya tenemos, y probándolos contra los datos, a veces podemos hacer nuevos conceptos y modelos a partir de los antiguos. Pero estas ventajas se ven compensadas por otros problemas. Las técnicas bayesianas pueden ayudarlo a elegir cuál de las dos hipótesis es más probable, pero casi siempre hay una enorme cantidad de hipótesis posibles, y ningún sistema puede considerarlas de manera eficiente. ¿Cómo decides qué hipótesis vale la pena probar en primer lugar?

Brenden Lake de NYU y sus colegas han utilizado este tipo de métodos de arriba hacia abajo para resolver otro problema que es fácil para las personas pero extremadamente difícil para las computadoras: reconocer caracteres escritos a mano desconocidos. Mira un personaje en un pergamino japonés. Incluso si nunca lo has visto antes, probablemente puedas saber si es similar o diferente de un personaje en otro pergamino japonés. Probablemente puedas dibujarlo e incluso diseñar un personaje japonés falso basado en el que ves, uno que se verá bastante diferente de un personaje coreano o ruso.

El método ascendente para reconocer los caracteres escritos a mano es dar a la computadora miles de ejemplos de cada uno y dejar que saque las características más destacadas. En cambio, Lake et al. le dio al programa un modelo general de cómo dibujar un personaje: un trazo va hacia la derecha o hacia la izquierda; después de terminar uno, comienzas otro; y así. Cuando el programa vio un personaje en particular, pudo inferir la secuencia de trazos que más probablemente lo condujeron a él, tal como deduje que el proceso de spam llevó a mi dudoso correo electrónico. Entonces podría juzgar si un nuevo personaje podría resultar de esa secuencia o de una diferente, y podría producir un conjunto similar de trazos. El programa funcionó mucho mejor que un programa de aprendizaje profundo aplicado exactamente a los mismos datos, y reflejó de cerca el desempeño de los seres humanos.

Estos dos enfoques para el aprendizaje automático tienen fortalezas y debilidades complementarias. En el enfoque de abajo hacia arriba, el programa no necesita mucho conocimiento para empezar, pero necesita una gran cantidad de datos y puede generalizarse solo de manera limitada. En el enfoque de arriba hacia abajo, el programa puede aprender de solo unos pocos ejemplos y hacer generalizaciones mucho más amplias y variadas, pero para empezar, necesita incorporar mucho más. Varios investigadores están intentando combinar los dos enfoques, utilizando el aprendizaje profundo para implementar la inferencia bayesiana.

El éxito reciente de la IA es en parte el resultado de extensiones de esas viejas ideas. Pero tiene más que ver con el hecho de que, gracias a Internet, tenemos muchos más datos, y gracias a la Ley de Moore tenemos mucho más poder computacional para aplicar a esos datos. Además, un hecho poco apreciado es que los datos que tenemos ya han sido ordenados y procesados por seres humanos. Las imágenes de gatos publicadas en la Web son imágenes canónicas de gatos, imágenes que los humanos ya han elegido como "buenas" imágenes. Google Translate funciona porque aprovecha millones de traducciones humanas y las generaliza a un nuevo texto, en lugar de comprender realmente las oraciones en sí.

Pero lo verdaderamente notable de los niños humanos es que de alguna manera combinan las mejores características de cada enfoque y luego van mucho más allá de ellos. Durante los últimos quince años, los especialistas en desarrollo han estado explorando la forma en que los niños aprenden la estructura de los datos. Los niños de cuatro años pueden aprender tomando solo uno o dos ejemplos de datos, como lo hace un sistema de arriba hacia abajo, y generalizando a conceptos muy diferentes. Pero también pueden aprender nuevos conceptos y modelos a partir de los datos mismos, como lo hace un sistema ascendente.

Por ejemplo, en nuestro laboratorio les damos a los niños pequeños un "detector de bicket", una nueva máquina para descubrir, una que nunca antes habían visto. Es una caja que se ilumina y reproduce música cuando le pones ciertos objetos pero no otros. Les damos a los niños solo uno o dos ejemplos de cómo funciona la máquina, mostrándoles que, digamos, dos bloques rojos lo hacen funcionar, mientras que una combinación verde y amarilla no lo hace. Incluso los jóvenes de dieciocho meses descubren de inmediato el principio general de que los dos objetos tienen que ser iguales para hacerlo funcionar, y generalizan ese principio a nuevos ejemplos: por ejemplo, elegirán dos objetos que tengan la misma forma para hacer La máquina funciona. En otros experimentos, hemos demostrado que los niños incluso pueden darse cuenta de que algunas propiedades invisibles ocultas hacen funcionar la máquina, o que la máquina funciona según algún principio lógico abstracto.

También puede mostrar esto en el aprendizaje diario de los niños. Los niños pequeños aprenden rápidamente teorías abstractas intuitivas de biología, física y psicología de la misma manera que lo hacen los científicos adultos, incluso con relativamente pocos datos.

Los notables logros de aprendizaje automático de los sistemas de IA recientes, tanto de abajo hacia arriba como de arriba hacia abajo, tienen lugar en un espacio estrecho y bien definido de hipótesis y conceptos: un conjunto preciso de piezas y movimientos del juego, un conjunto predeterminado de imágenes . En contraste, los niños y los científicos a veces cambian sus conceptos de manera radical, realizando cambios de paradigma en lugar de simplemente modificar los conceptos que ya tienen.

Los niños de cuatro años pueden reconocer inmediatamente a los gatos y comprender las palabras, pero también pueden hacer nuevas inferencias creativas y sorprendentes que van mucho más allá de su experiencia. Mi propio nieto explicó recientemente, por ejemplo, que si un adulto quiere volver a ser niño, debe intentar no comer vegetales saludables, ya que los vegetales saludables hacen que un niño se convierta en adulto. Este tipo de hipótesis, plausible que ningún adulto jamás entretendrá, es característica de los niños pequeños. De hecho, mis colegas y yo hemos demostrado sistemáticamente que los preescolares son mejores para formular hipótesis poco probables que los niños mayores y los adultos. Casi no tenemos idea de cómo es posible este tipo de aprendizaje creativo e innovación.

Sin embargo, observar lo que hacen los niños puede dar a los programadores pistas útiles sobre las instrucciones para el aprendizaje de la computadora. Dos características del aprendizaje de los niños son especialmente llamativas. Los niños son aprendices activos; no solo absorben pasivamente los datos como lo hacen las IA. Al igual que los científicos experimentan, los niños están intrínsecamente motivados para extraer información del mundo que los rodea a través de su juego y exploración sin fin. Estudios recientes muestran que esta exploración es más sistemática de lo que parece y está bien adaptada para encontrar evidencia persuasiva para apoyar la formación de hipótesis y la elección de la teoría. Construir curiosidad en las máquinas y permitirles interactuar activamente con el mundo podría ser una ruta hacia un aprendizaje más realista y amplio.

En segundo lugar, los niños, a diferencia de las IA existentes, son aprendices sociales y culturales. Los humanos no aprenden de forma aislada, sino que aprovechan la sabiduría acumulada de las generaciones pasadas. Estudios recientes muestran que incluso los preescolares aprenden a través de la imitación y escuchando el testimonio de otros. Pero no simplemente obedecen pasivamente a sus maestros. En cambio, reciben información de otros de una manera notablemente sutil y sensible, haciendo inferencias complejas sobre de dónde proviene la información y cuán confiable es e integrando sistemáticamente sus propias experiencias con lo que están escuchando.

La "inteligencia artificial" y el "aprendizaje automático" suenan atemorizantes. Y de alguna manera lo son. Estos sistemas se están utilizando para controlar armas, por ejemplo, y realmente deberíamos tener miedo al respecto. Aún así, la estupidez natural puede causar muchos más estragos que la inteligencia artificial; Los humanos tendremos que ser mucho más inteligentes de lo que hemos sido en el pasado para regular adecuadamente las nuevas tecnologías. Pero no hay mucha base para la visión apocalíptica o utópica de las IA que reemplazan a los humanos. Hasta que resolvamos la paradoja básica del aprendizaje, las mejores inteligencias artificiales no podrán competir con el humano promedio de cuatro años.

De la próxima colección POSSIBLE MINDS: 25 Ways of Looking at AI, editado por John Brockman. Publicado por acuerdo con Penguin Press, miembro de Penguin Random House LLC. Derechos de autor © 2019 John Brockman.