A medida que avanzan las interfaces de usuario, apretar un clicker suave con Bluetooth del tamaño de un chicle es una de las formas más extrañas de seleccionar, mover, hacer clic o controlar una computadora. Pero para ciertas situaciones, en realidad tiene mucho sentido. Digamos que está montando una bicicleta y desea responder una llamada en su auricular o buscar instrucciones, pero no quiere quitar las manos de las barras. O si está paralizado y necesita conducir una silla de ruedas eléctrica, una almohadilla direccional discreta en su boca será mucho menos notable que un dispositivo estándar de control de boca o mentón, o incluso uno que presione con el hombro.

"¿Cómo podemos reproducir estas interacciones mientras mantenemos la discreción de la interfaz?", Dice Pablo Gallego, uno de los inventores del dispositivo, llamado ChewIt. “La gente no puede saber si estás interactuando con ChewIt, o si tienes goma de mascar o una goma dentro de la boca. O tal vez un caramelo.

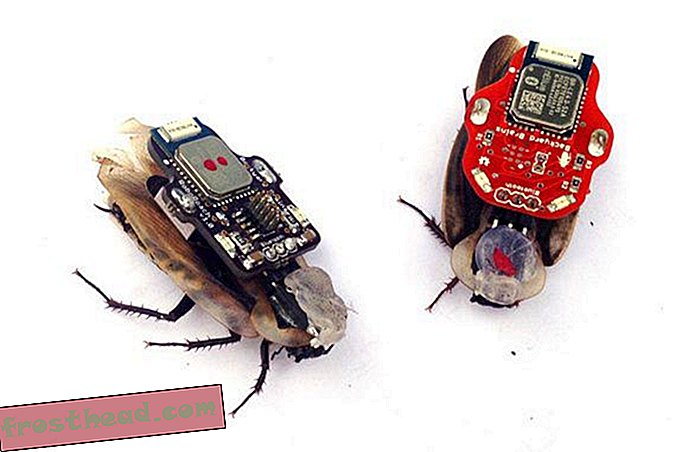

Gallego se decidió por esta idea, decidido a refinarla y crear un prototipo en pos de su maestría en ingeniería en la Universidad de Auckland en Nueva Zelanda. La investigación mostró que los humanos pueden reconocer formas distintas en la boca, al igual que con la punta de los dedos. Y él sabía que podemos tolerar chicle y otros objetos extraños. Lo que siguió fueron años de trabajo, optimizando el factor de forma. Un objeto redondo no funcionaría; el usuario no pudo decir cómo estaba orientado. Tenía que ser lo suficientemente grande como para controlar, pero lo suficientemente pequeño como para esconderse en la mejilla. Junto con el compañero de investigación Denys Matthies, Gallego hizo ChewIt con una gota asimétrica de resina de polímero que contenía una placa de circuito con un botón que puede controlar y mover una silla.

Este prototipo de ChewIt muestra la resina de polímero y la placa de circuito. (Universidad de Auckland)

Este prototipo de ChewIt muestra la resina de polímero y la placa de circuito. (Universidad de Auckland) Gallego y Matthies concibieron y construyeron ChewIt en el Laboratorio Humano Aumentado de la Universidad de Auckland, un profesor de ingeniería del grupo de investigación Suranga Nanayakkara se reunió para inventar herramientas diseñadas para adaptar la tecnología para uso humano, en lugar de al revés. Hay un desajuste, razonó Nanayakkara, entre lo que hace nuestra tecnología y cómo interactúa con nosotros. No deberíamos tener que aprenderlo; Debería aprendernos.

"La poderosa tecnología, mal diseñada, hará que los usuarios se sientan discapacitados", dice Nanayakkara. “La tecnología poderosa con la interfaz hombre-máquina adecuada hará que las personas se sientan empoderadas, y eso hará que la interacción de persona a persona en primer plano, [y] mantenga la tecnología en un segundo plano. Ayuda a aprovechar todo el potencial de la tecnología ".

Nanayakkara ha hecho todo lo posible para garantizar que los estudiantes y científicos de su prolífico laboratorio puedan crear en función de sus intereses y colaborar entre ellos en sus ideas. La variedad de tecnologías que han desarrollado es notable. Hay una alfombra de bienvenida que reconoce a los residentes en función de su huella, incluido el peso del usuario y los perfiles de desgaste de las suelas, y abre la puerta para ellos. Hay un entrenador de memoria personal que se involucra a través del audio en momentos en que reconoce que el usuario tiene el tiempo y la atención para practicar. Hay un bate de cricket inteligente que ayuda a los usuarios a practicar su agarre y swing. Hay un detector de pasos para ayudas para caminar para los ancianos, porque los FitBits y los relojes inteligentes a menudo cuentan mal los pasos cuando las personas usan rodillos.

Y hay GymSoles. Estas plantillas inteligentes actúan como un entrenador de levantamiento de pesas, ayudando a los usuarios a mantener la forma y la postura correctas durante las sentadillas y los pesos muertos. "Estas tienen posturas muy distintas", dice Samitha Elvitigala, quien está construyendo el dispositivo como parte de su candidatura a doctorado. “Hay algunos movimientos sutiles que debes seguir, de lo contrario terminarás con lesiones”. Los sensores en las plantas rastrean el perfil de presión de los pies, calculan el centro de presión y lo comparan con el patrón que debería ser: digamos, si el levantador de pesas se inclina demasiado hacia atrás o demasiado hacia adelante. Luego, el dispositivo proporciona retroalimentación háptica en forma de vibraciones sutiles, lo que indica cómo debe alinearse el levantador. Al ajustar su inclinación y la posición de sus pies, piernas y caderas correctamente, todo el cuerpo cae en la forma adecuada. Elvitigala todavía está refinando el proyecto y estudiando cómo podría usarse para otras aplicaciones, como mejorar el equilibrio en pacientes con Parkinson o víctimas de accidente cerebrovascular.

El origen del Laboratorio Humano Aumentado se remonta a una experiencia que Nanayakkara tuvo en la escuela secundaria. Trabajando con estudiantes en una escuela residencial para sordos, se dio cuenta de que todos menos él se comunicaban sin problemas. Le hizo repensar la comunicación y las habilidades. "No siempre se trata de corregir la discapacidad, se trata de conectarse con las personas", dice. "Sentí que necesitaba algo para conectarme con ellos". Más tarde, notó un problema similar en la comunicación con las computadoras.

Aprendió a pensar en ello como un problema de diseño mientras estudiaba ingeniería, y luego como un postdoctorado en el grupo de Interfaces de Fluidos del científico informático Pattie Maes, parte del MIT Media Lab. Al igual que el Laboratorio Humano Aumentado, el grupo de Fluid Interfaces crea dispositivos diseñados para mejorar la capacidad cognitiva a través de interfaces informáticas sin interrupciones.

"Los dispositivos juegan un papel en nuestras vidas, y en este momento su impacto es muy negativo, en nuestro bienestar físico, nuestro bienestar social", dice Maes. "Necesitamos encontrar formas de integrar mejor los dispositivos en nuestras vidas físicas, nuestras vidas sociales, para que sean menos perjudiciales y tengan menos efectos negativos".

El objetivo, dice Maes, no es hacer que las computadoras hagan todo por nosotros. Estaremos mejor si nos pueden enseñar a hacer mejor las cosas nosotros mismos y ayudarnos como lo hacemos. Por ejemplo, sus alumnos diseñaron un par de anteojos que rastrean los movimientos oculares y el EEG de los usuarios, y les recuerdan que se concentren en una lectura o lectura cuando su atención está disminuyendo. Otro usa la realidad aumentada para ayudar a los usuarios a mapear recuerdos en las calles mientras caminan, una técnica de memorización espacial que los campeones de la memoria denominan "palacio de la memoria". Compárelo con Google (tal vez busque "disfraces de Halloween" en lugar de ser creativo, dice Maes ) o Google Maps, que han reemplazado en gran medida nuestra necesidad de retener información o comprender dónde estamos.

"A menudo olvidamos que cuando utilizamos un servicio como este, que nos aumenta, siempre hay un costo", dice ella. “Muchos de los dispositivos y sistemas que construimos aumentan a una persona con ciertas funciones. Pero cada vez que aumenta alguna tarea o habilidad, a veces también pierde un poco de esa habilidad ".

Quizás el dispositivo más conocido de Nanayakkara, el FingerReader, comenzó en su tiempo en el MIT. Diseñado para personas con discapacidad visual, FingerReader es simple en su interfaz: apunte la cámara de anillo a algo, haga clic, y el dispositivo le dirá qué es, o leerá cualquier texto que contenga, a través de un conjunto de auriculares.

FingerReader siguió a Nanayakkara a Singapur, donde comenzó el Laboratorio Humano Aumentado en la Universidad de Tecnología y Diseño de Singapur, y luego a la Universidad de Auckland, donde trasladó a su equipo de 15 personas en marzo de 2018. * En ese momento, él y su los estudiantes han refinado FingerReader y han realizado versiones posteriores. Al igual que muchos de los otros dispositivos, FingerReader está patentado (provisionalmente) y algún día podría llegar al mercado. (Nanayakkara fundó una startup llamada ZuZu Labs para producir el dispositivo, y está produciendo una prueba de unos pocos cientos de piezas).

De alguna manera, la expansión de asistentes virtuales como Siri, Alexa y Google Assistant están abordando problemas similares. Permiten una interfaz más natural, una comunicación más natural entre las personas y sus computadoras ubicuas. Pero para Nanayakkara, no obvian sus dispositivos, solo ofrecen una nueva herramienta para complementarlos.

"Estas tecnologías habilitadoras son excelentes, tienen que suceder, así es como avanza el campo", dice. “Pero alguien tiene que pensar en cómo aprovechar mejor todo el poder de esos. ¿Cómo puedo aprovechar esto para crear la próxima interacción hombre-máquina más emocionante? ”

* Nota del editor, 15 de abril de 2019: una versión anterior de este artículo declaró incorrectamente que Suranga Nanayakkara trasladó a su equipo de la Universidad de Tecnología y Diseño de Singapur a la Universidad de Auckland en mayo de 2018, cuando en realidad fue en marzo de 2018. La historia ha sido editada para corregir ese hecho.